Содержание

- Что такое битые ссылки

- Происхождение битых ссылок: почему они появляются

- Анализ ошибок на сайте: как найти битые ссылки

- Десктопные сервисы для проверки Sitemap

- Онлайн-сервисы для анализа битых ссылок

- Как избавляться от битых ссылок в sitemap. xml

В создании, продвижении и поддержке сайтов существует множество подводных камней. Например, одно из самых слабых мест - это появление на сайте битых ссылок, которые обычно сопровождаются 404-ошибками («Страница не найдена» или «404 Not Found»). Такие вещи портят пользовательский опыт и ведут к потере трафика. Люди не получают нужной информации и уходят на сайт ваших конкурентов.

Сейчас мы расскажем подробнее том, откуда берутся битые ссылки, а также о том, как с ними бороться.

Что такое битые ссылки

Битой называют ссылку на несуществующую страницу. URL искомой страницы удален или изменен, но в навигации для пользователей эти изменения не учтены.

Существует два типа битых ссылок: внутренние и внешние. Внутренние ведут на страницы того же ресурса, внешние - на сторонние площадки. И если страница, на которую ведет ссылка, больше не существует, при переходе на нее выскакивает оповещение: «Ошибка 404». Это стандартный ответ сервера, который сообщает пользователю, что нужная страница не найдена и переход на нее невозможен.

Как это работает:

- Перед открытием любой страницы браузер обращается к серверу с запросом.

- Сервер проводит анализ документов или файлов и открывает заголовок с необходимыми данными.

- При нормальном функционировании системы и сайта происходит кодировка «200 ОК» и юзер попадает на нужную страницу.

- Если на сайте что-то работает некорректно, сервер выдает пользователю ошибку «404». Чтобы этого не происходило, необходимо проверять Sitemap на битые ссылки и своевременно их устранять. Анализ и проработка сайта позволят избежать нежелательных последствий этой ошибки.

Почему появляются битые ссылки

Рассмотрим основные причины появления страниц «Error 404» и «Not found»:

- документ с сайта удален;

- сервер работает некорректно;

- URL страницы был изменен или в нем присутствует ошибка.

1. Удаление неактуальных страниц и файлов

Все страницы сайта образуют общую систему и связаны. Удаление или неверная работа любой из них автоматически ведут к появлению битых ссылок на всех страницах, которые ссылались на удаленную. Одна такая страница может привести к десяткам нерабочих ссылок, поэтому так важно проверять сайт на ошибки и устранять их.

Например, существует такое понятие, как «временные внутренние страницы» на сайте. Они создаются на непродолжительный период, и когда необходимость в них отпадает, удаляются. Важно помнить, что вместе со страницей нужно подчищать и ведущие на нее ссылки.

Внешние ссылки могут стать битыми, если сторонний сайт, на который они вели, неисправен или перестал существовать. Например, если его владелец не продлил домен.

Как решить проблему: перед тем как удалить страницу с сайта, поставьте с нее «301» редирект на более релевантную страницу.

2. Изменения в структуре сайта

Когда админ создает новые подразделы, то к ним могут подтягиваться уже существующие веб-страницы.

Пример:

В этом случае перелинковка может «поплыть», и часть гиперссылок станет нерабочей. Потому рекомендуем регулярно проверять работоспособность всех страниц сайта.

3. Ошибки разработчиков, контент-менеджеров, вебмастеров

Человеческий фактор также может приводить к появлению битых ссылок. И программисты, и вебмастера, и контентщики - живые люди, которые при перелинковке могут поставить не тот адрес или допустить опечатку. В результате ссылка будет нерабочей. Чтобы свести риск таких ситуаций к минимуму, сразу после создания страницы нужно проверять каждую ссылку.

Анализ ошибок на сайте: как найти битые ссылки

Мы уже говорили об этом выше, и повторим снова - возьмите за правило регулярно проверять сайт на наличие битых ссылок. Частота такого мониторинга зависит от объемов трафика и типа площадки. Например, на новостном портале или в крупном интернет-магазине это нужно делать в разы чаще, чем на одностраничнике.

Поиск битых ссылок превращается в ад, если проверять каждую ссылку на сайте в ручную, просто кликая по ней. Быстро и эффективно исправлять ошибки в урлах помогут профильные инструменты, которых сейчас существует множество. Рассмотрим некоторые из них.

Десктопные сервисы для проверки Sitemap

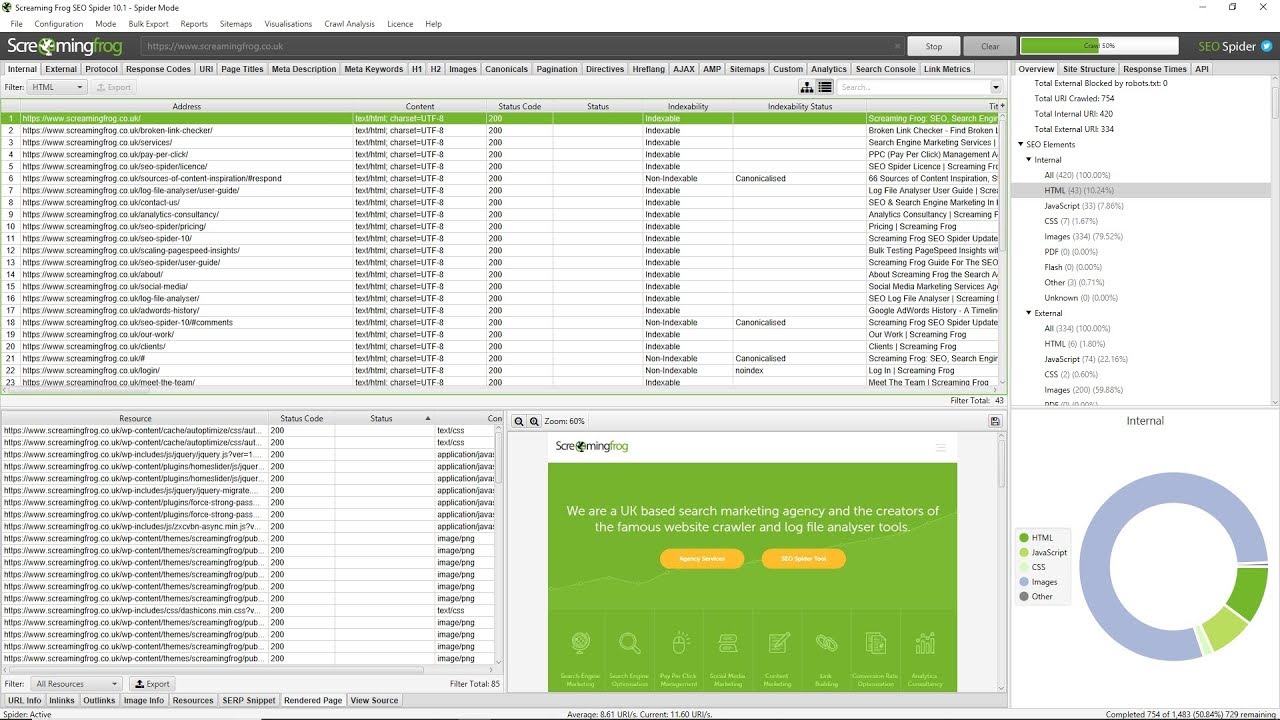

Screaming Frog SEO Spider Tool - удобная программа с большим количеством параметров настройки, совместима с Mac OS, Windows, Linux. Кроме платной версии, у нее существует и бесплатная, но в ней, естественно, есть ограничения (например, можно проверить не более 500 URL). Для анализа сайта с десятками тысяч страниц программа не подойдет, но вычистить небольшой молодой ресурс или одностраничник она поможет.

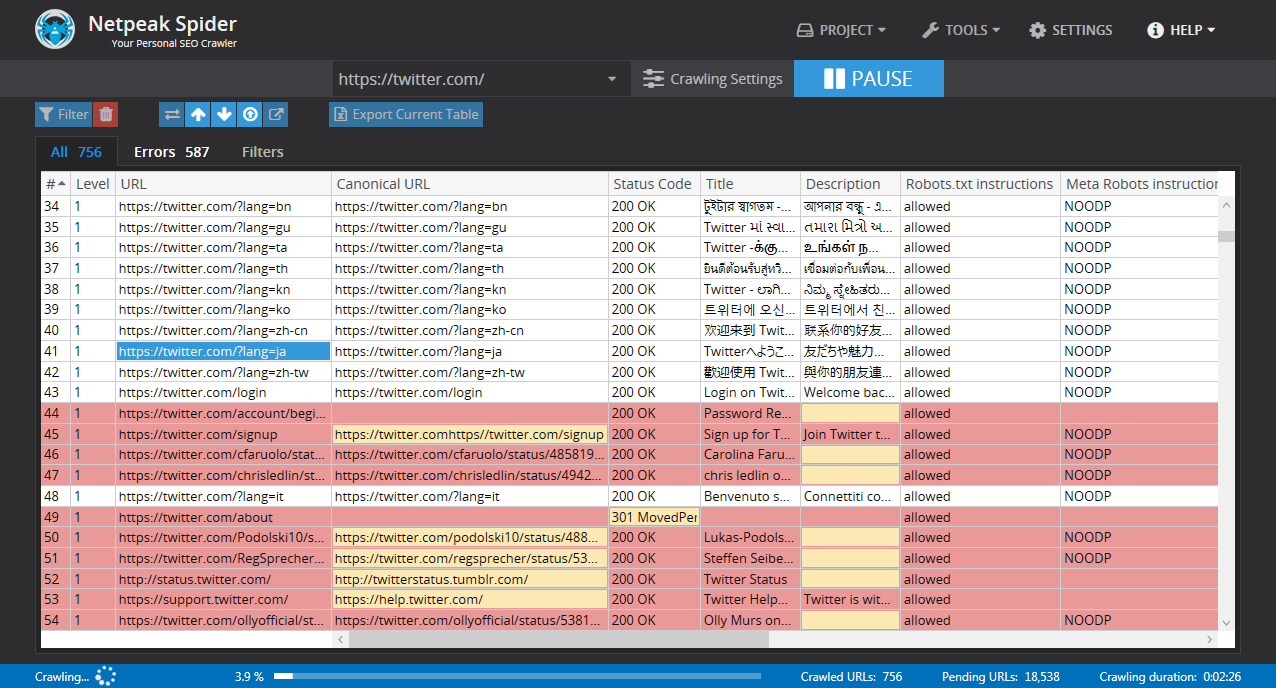

Netpeak Spider. Еще одна хорошая программа для проверки сайта. Основные плюсы: простота интерфейса и широкий выбор параметров настроек. Совместима программа с Windows и Mac OS. Инструмент представлен только в платной версии с двухнедельным триал-режимом.

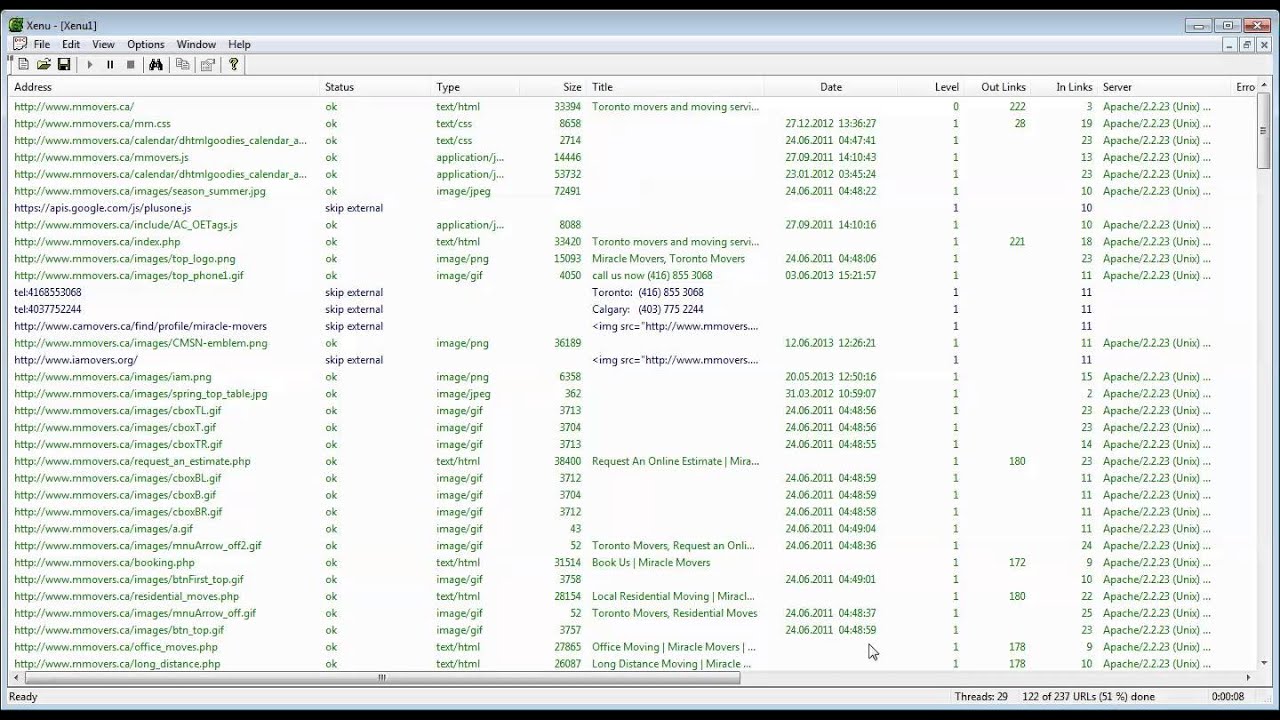

Xenu's Link Sleuth. Инструмент бесплатный и его функционал позволяет не только находить битые ссылки, но это главные плюсы утилиты. Из минусов: целевой сайт может тормозить из-за частых запросов программы. На анализ большой онлайн-площадки у Xenu's Link Sleuth может уходить до нескольких часов. Утилита совместима только с Windows.

Десктопные инструменты для поиска битых ссылок удобны, но их нужно скачивать-устанавливать и функционируют они только на десктопных устройствах, что не всегда удобно.

Онлайн-сервисы для анализа битых ссылок

Рассмотрим популярные онлайн-сервисы для проверки сайтов на ошибки.

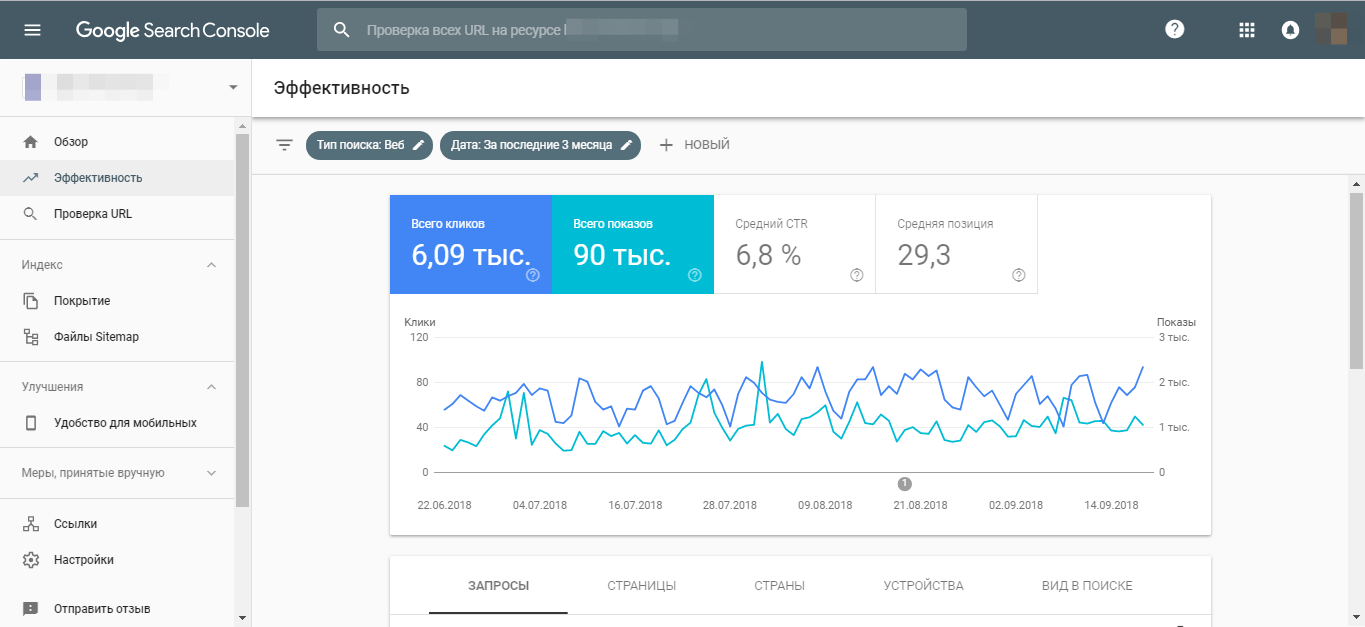

Google.Вебмастер - бесплатный онлайн-сервис, который выдает информацию обо всех ссылках с ошибками. Чтобы увидеть результаты, собранные валидатором Sitemap Google, нужно перейти в отчет: «Сканирование» > «Ошибки сканирования».

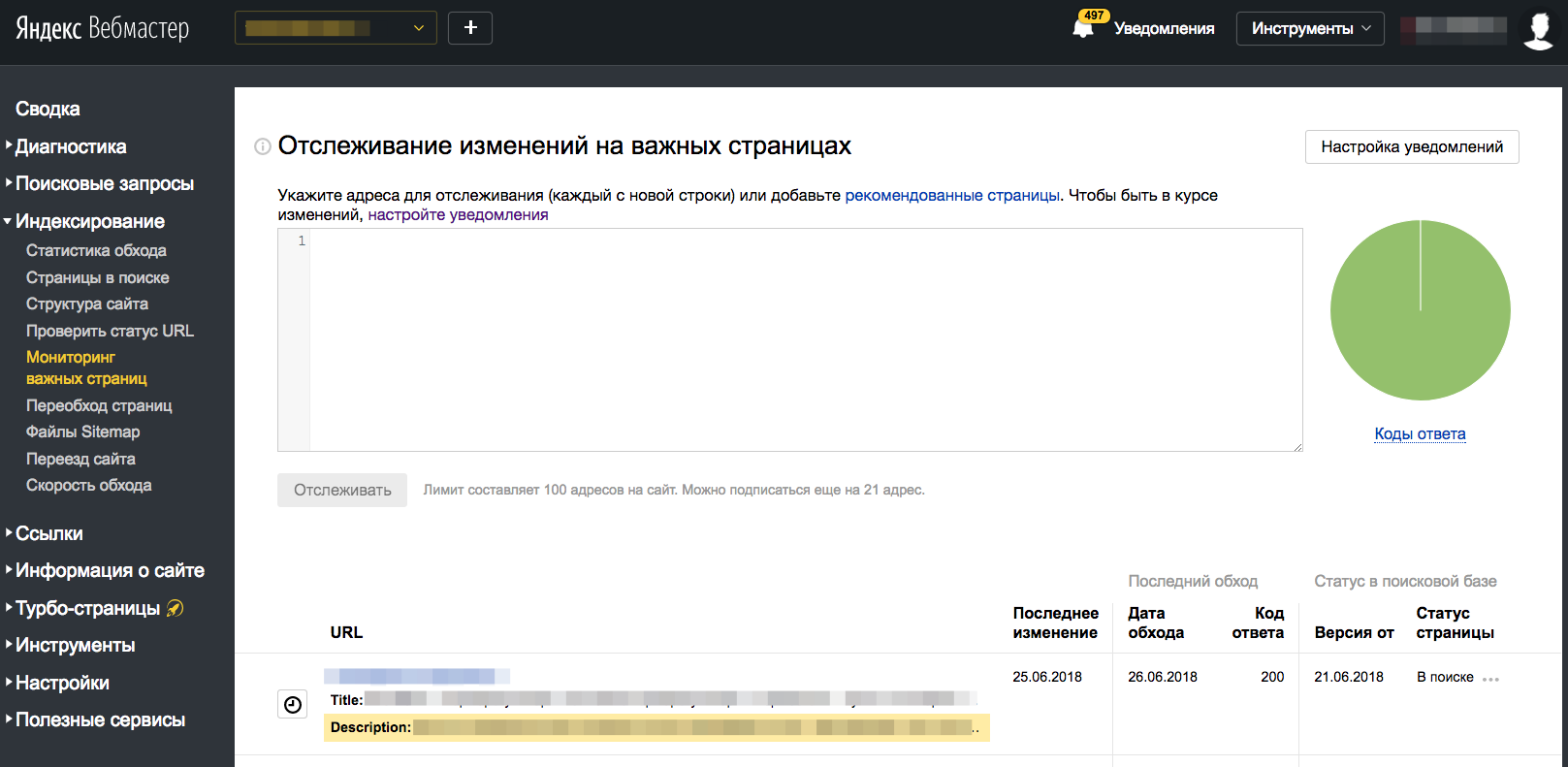

Яндекс.Вебмастер - практически полный аналог варианта от Гугла, но интерфейс не настолько дружественный. Мы бы рекомендовали пользоваться инструментом от Google.

Работать с обоими этими сервисами несложно - обычно достаточно указать адрес сайта. Также у Гугла, например, есть подробные инструкции о том, как создать и найти sitemap. xml на сайте и множество полезных практических рекомендаций.

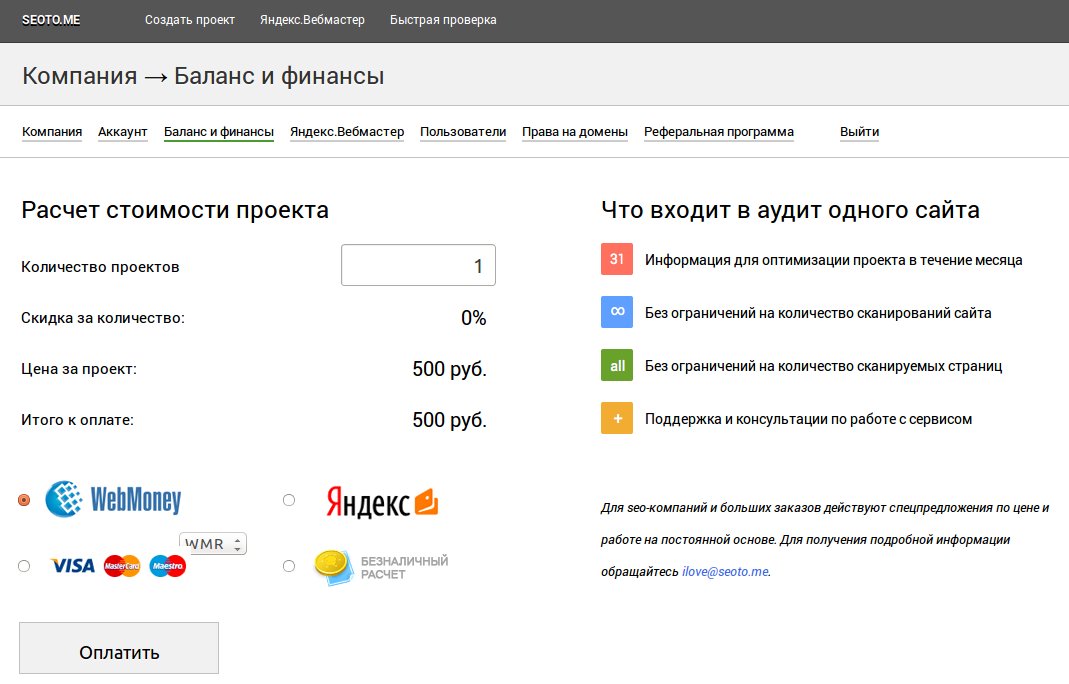

Seoto.me - онлайн-программа с удобным интерфейсом и обилием параметров настроек. Она позволяет анализировать и оптимизировать площадки любого веса, вплоть до сайтов-миллионников. Но программа платная, стоимость единичного скана сайта обойдется в сумму от 500 рублей.

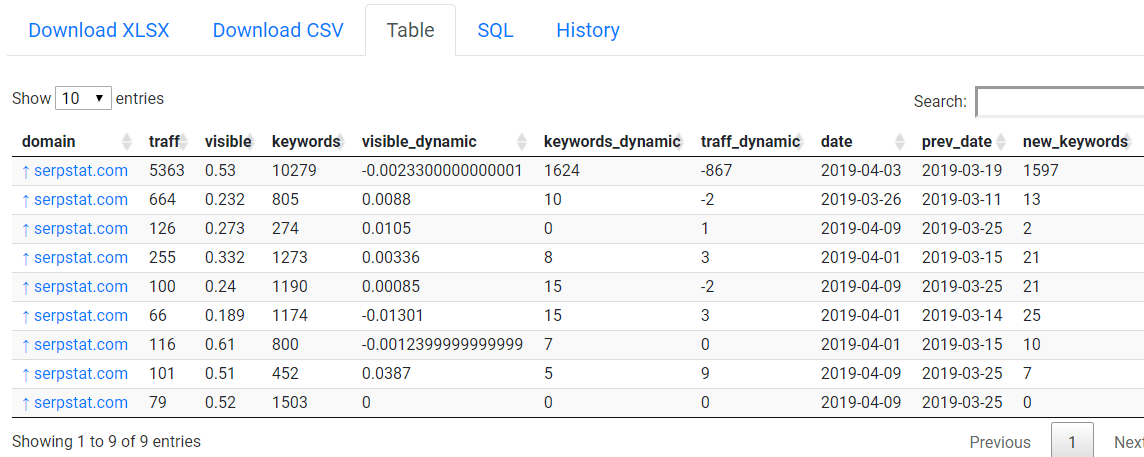

Serpstat.com - комплексная программа, совмещающая функцию валидатора sitemap. xml и другой веб-аналитики со сбором семантики, анализом конкурентов и другими опциями. Сервис позволяет провести ускоренный мониторинг площадки, сравнить динамику прогрессов после изменений и т.д. На сайте, так же, как и в Гугл вебмастере, есть инструкции о том, как посмотреть sitemap сайта, проверить валидность верстки и о многом другом. Программа платная. Если вам нужен регулярный аудит нерабочих ссылок или вас интересует не только он, рекомендуем Serpstat.com.

Как избавляться от битых ссылок в sitemap.xml

Для удаления битых ссылок можно воспользоваться одним из способов:

- вручную исправлять нерабочие ссылки на актуальные;

- настраивать «301» редирект (в файле .htaccess. При смене движка или структуры сайта можно задать постоянный постраничный «301» редирект).

На заметку: засилье внутренних редиректов может плохо влиять на работу сайта, поэтому предпочтительнее использовать метод исправления битых ссылок на работающие.